皆さん、ChatGPTみたいなAIの返答を待っていて「遅いなぁ…」とヤキモキした経験、ありませんか?実は舞台裏では、GPUが全力を出し切れておらず利用率が10~15%程度に留まっていることも多く、計算資源が大幅に余っているのです。そのうえ入力が長くなるとメモリが逼迫し、キャッシュが行ったり来たりして余計に処理が遅くなる(いわゆるスラッシング)など、大規模AIの推論には隠れた非効率がたくさんあります。結果として応答に時間がかかったり、必要以上にGPU台数を増やすハメになってコストが激増したり…ユーザーも開発者も困っちゃう状況なんです。

そんな生成AIの推論(Inference)の悩みを一挙に解決する秘密兵器として、NVIDIAが新たに発表したのがNVIDIA Dynamo(ダイナモ)です。簡単に言えば、これは大規模な生成AIモデルをマルチGPU環境で効率良くさばくためのオープンソース推論フレームワークで、GPU資源の動的スケジューリング、賢いリクエストの振り分け(ルーティング)、メモリ管理の最適化、高速なデータ転送などが組み込まれています。おまけにNVIDIAいわく条件によっては最大で30倍ものリクエストをさばける性能向上を達成したとか。本記事では、このNVIDIA Dynamoが一体何をしてそんな劇的な効果を生んでいるのか、ゆるい語り口で楽しく解説していきます。

なぜDynamoが必要なのか?~生成AI推論の課題~

近年、AIモデルはますます

巨大化するとともに「推論中に考える(理由付けを行う)」能力まで身につけ、1回の応答で吐き出すトークン(単語や文字列)も爆発的に増えています。企業でのジェネレーティブAI活用も急増しており、2024年の調査では

67%の企業が生成AIを業務に組み込み始めているとの報告もあります。需要がうなぎ登りなのは良いとして、問題は

それを支える推論インフラです。従来のやり方では、このスケールについていけなくなりつつあります。

最大の課題の一つは前述の通り

GPUのリソースが有効活用されていないことです。例えば大規模言語モデルの推論には大きく分けて2つのフェーズがあります。一つはユーザーからの長文プロンプトを読み込んで内部状態を構築する「前処理(Prefill)」フェーズ。もう一つはそれを元に次々と単語を生成していく「デコード(Decode)」フェーズ

です。実はこの2フェーズ、計算の性質が全然違います。前処理は主に行列積計算

などGPUコアをフル回転させる演算が中心で「計算(演算)Bound」な処理。一方、デコードは過去の生成結果を保持したキー・バリューキャッシュ

(KVキャッシュ)を読み書きするメモリアクセス

が多く「メモリBound

」な処理です。なのに従来はこの異なる2つを同じGPU上で連続して*

行っていました。すると片方を実行している間、もう片方の資源(例えば演算ユニット or メモリ帯域)は遊んでしまい、GPUを100%使い切れないのです。これはもったいないですよね。

加えて、大規模モデルではKVキャッシュ(生成に必要な「文脈」データ)自体が非常に巨大になります。長いプロンプトや長文の応答では何百万ものベクトル(キー・バリュー対)が生成され、これを毎回GPUメモリ上に保持しておくのはコスト的にも容量的にも厳しくなります。かといって都度計算し直すと推論が遅くなりすぎます。この「広大な文脈」をいかに効率よく再利用・保存するかも大きな課題です。さらにマルチユーザー環境では、リクエストの内容によって効率よく処理順序や配置を決めないと一部のGPUに負荷が偏ったりキャッシュが無駄になったりします。

こうした問題を放置すると、応答の遅延(ユーザーが待たされる時間)が増大したり、要求に応じてGPUをどんどん増設しなければならずコストが跳ね上がったりします。つまりスケーラビリティの限界にぶつかるのです。生成AIの応答をリアルタイムで返すにはこれらを解決しなくてはなりません。NVIDIAはこの解決策として「AIモデルの工場(AI Factory)」というビジョンを掲げ、大量のトークン生成を低コストで回す仕組みが重要だと述べています。Dynamoはまさに、そのために生まれた「次世代の推論サーバ」であり、Triton(NVIDIAの従来の推論サーバ)の後継として大規模分散環境での効率化*に照準を定めたものなのです。では具体的にDynamoは何をするのでしょうか?次章で見てみましょう。

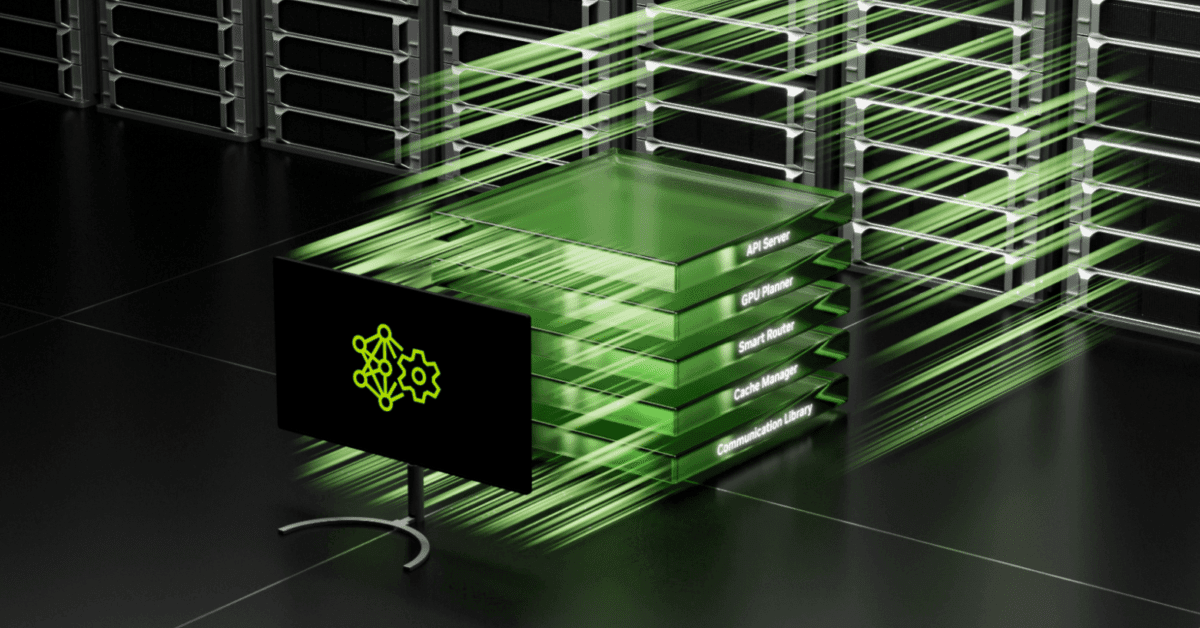

NVIDIA Dynamoのアーキテクチャと特徴

Dynamoが魔法のように見えるのは、推論処理の流れを根本から見直し最適化しているからです。主なポイントを順に紹介します。

-

プレフィルとデコードの分離(Disaggregated Serving):

図1: 従来の推論(左)では1つのマルチGPUノードで前処理とデコードを連続実行するため、計算資源とメモリ資源がお互いに干渉して非効率でした。Dynamoの分離アーキテクチャ(右)では前処理とデコードを

別々のGPU群に割り当て、前処理で得たKVキャッシュを速やかに他GPUへ転送してデコードを並行実行します。

前述のように性質の異なる

前処理フェーズとデコードフェーズを、異なるGPU(あるいはGPUクラスタ)に分けて実行します。これにより両フェーズが

お互いのリソースを食い合うことなく独立に最適化できるのがミソです。例えば前処理用のGPUは演算重視で高速クロックのものを、デコード用は大容量メモリや帯域重視の構成にするといったチューニングが可能になります。また前処理が終わったらすぐ次のリクエストに取りかかり、デコードは別GPUにバトンタッチすることで

パイプライン並列的に処理を走らせることもできます。要するに、一人のシェフが下ごしらえから盛り付けまでやっていたのを、

前菜担当とメイン担当に分業させて同時進行させるイメージです。その結果、GPU資源の有効活用率が大幅に上がりスループット(単位時間あたりの処理件数)が向上します。実際、これだけでも

生成性能が2倍以上に伸びるケースが報告されています(後述)。

-

GPUリソースプランナー(Dynamic GPU Scheduler):

リクエストの量や内容に応じて、

GPUの割り当てを自動で調整する仕組みです。例えば「今は長文の入力が多いから前処理GPUを多めに使おう」「ユーザーへの最初の応答速度(TTFT)は十分だけど後続のトークン生成(ITL)が遅いからデコード側にGPUを足そう」といった判断をリアルタイムに行います。事前に定めたサービス目標(SLO: 一定の遅延以下に抑える等)を守るため、Dynamoが

GPU資源の配分を賢く最適化してくれるイメージです。これにより過不足のないGPU運用が可能になり、ピーク時でも無駄なくスケールしつつアイドル時のリソース浪費も抑えられます。いわば

AIインフラのトラフィック信号機ですね。

-

スマートルーター(LLM-aware Smart Router):

長いプロンプトを入れると、その内容から生成に必要な

文脈(コンテキスト)がモデル内部に「KVキャッシュ」として蓄えられます。Dynamoのスマートルーターは、クラスタ全体でこのKVキャッシュの所在を把握し、新たなリクエストが来たとき

関連する文脈をすでに持っているGPUノードに優先的にルーティングします。これによって、同じような入力に対して

何度も同じ計算をやり直す非効率を大幅に削減できるのです。例えばシステムプロンプト(共通の指示文)や、ユーザごとのチャット履歴が既にどこかのGPUにキャッシュされていれば、そのGPUに続きの質問を送るだけで高速に応答できるというわけです。「この質問なら

あのサーバー君が下準備済みだ!」と見抜いて振り分けてくれる頭脳派ルーターです。これにより

不要な前処理計算を回避し平均応答時間が短縮されたというデータも出ています。特に

単一ユーザーとのマルチターン対話(チャットの続き)やエージェント型AIの複数ステップ推論などで威力を発揮します。

-

分散KVキャッシュ・マネージャ(Distributed KV Cache Manager):

とはいえKVキャッシュを際限なくGPUメモリに溜め込んでおくのは容量的・コスト的に無理があります。そこでDynamoでは

使われなくなった過去のKVキャッシュを安価なストレージにどんどん退避させる仕組みを備えています。具体的には、古いキャッシュや参照頻度の低いデータはCPUのホストメモリやローカルSSD、はたまたネットワーク上のオブジェクトストレージ(クラウドストレージ)などにエヴィクション(移動)します。そして必要になったら素早くGPUに呼び戻す。これを自動でやってくれるのがKVキャッシュ・マネージャです。これにより

GPUメモリという貴重で高価な資源を常に最新の必要データに割り当てつつ、過去の文脈も捨てずに取っておけるのです。極端に言えば

ペタバイト級の会話履歴だってクラウドストレージに保管しておけます。しかもユーザ体験を損なわないよう

頻繁に使うデータはGPU側に優先保持し、あまり使わないものから追い出すポリシー制御も備えています。これで「過去の計算を再利用したいけどメモリが足りない!」というジレンマを解決しているのです。

-

NIXL(NVIDIA Inference Transfer Library)による高速データ転送:

上記の仕組みを成り立たせるための縁の下の力持ちが、この

NIXLと呼ばれる通信ライブラリです。一言でいうと、

GPU間やGPUとCPU/ストレージ間のデータ移動を超低遅延・高速にやるための専用エンジンです。GPU直接通信技術(例えばNVLinkやInfiniBandなど)からNVMe SSD、はたまたイーサネット経由のクラウドストレージまで、ありとあらゆる経路を抽象化し最適な方法でデータを送受信してくれます。DynamoはこのNIXLのおかげで、先述の

KVキャッシュ転送をミリ秒未満の遅延で実現できるのです。つまり前処理GPUで計算した文脈データを即座にデコードGPUに引き継いだり、保管していたキャッシュを必要なとき瞬時に引き出したりできます。イメージ的には「GPU間でテレパシー送信してる」ぐらいの感覚でしょうか。NIXL自体はオープンソースで、他の通信バックエンド(例えばUCXやS3 APIなど)とも共通インタフェースで繋げる柔軟性もあります。要するに

高速かつハードウェアにとらわれないデータ配達屋で、Dynamoの円滑な分散処理に欠かせないピースです。

以上がDynamoの主なアーキテクチャ上の工夫です。この他にも細かい最適化はありますが、中心となるのは「

前処理と生成の役割を分離する」「

キャッシュ(文脈)を賢く使い回す」「

ハード資源の配分と通信を最適化する」の三本柱だと言えるでしょう。では実際どれほどの効果があるのか、次にベンチマーク結果を見てみましょう。

どれだけ速くなった?驚異の性能向上データ

肝心の性能ですが、NVIDIAによるとDynamoの導入で

文字通りケタ違いのスピードアップが得られています。いくつか具体例を紹介しましょう。

まず圧巻なのが、

DeepSeek-R1というオープンソースの超巨大モデル(なんと

6710億パラメータ!)を使ったテストです。従来手法ではとても手に負えない規模のモデルですが、NVIDIAの次世代GPUを大量に繋いだクラスタ上でDynamoを使って推論を回したところ、

1つのGPUあたり処理できるトークン数(スループット)が従来比で最大30倍に達したと報告されています (

What is Nvidia Dynamo and why does it matter to enterprises? | Network World)。

30倍ですよ!?ここまでくると「もはや別次元、突然変異的な速さ」と言っても過言ではありません。実際、この結果は

従来は1リクエストさばくのに30台のGPUが必要だったところ、たった1台で済んだことを意味します(極端に単純化すれば…ですが)。モデルが巨大になればなるほどDynamoの効能が光る好例でしょう。

とはいえ「671B(6,710億)パラメータなんてウチでは扱わないよ…」という方もご安心を。もっと一般的な大規模モデルでもDynamoはちゃんと効きます。例えば人気のオープンソースLLMである

Llama2 70B(700億パラメータ)を単一ノードの最新GPU上で動かすケースでは、Dynamo使用時にスループットが約2倍以上に向上しています。たかが2倍と思うなかれ、ビジネスの現場で同じハードで処理できるユーザー数が倍になるインパクトは絶大です。実際リアルタイム応答が求められるチャットサービス等では、この差がサービスの成否を分けることもあるでしょう。

また

応答のレスポンス(遅延)面でも改善が報告されています。例えば社内実験で

10万件規模の実ユーザー質問を使ったベンチマークでは、Dynamoのスマートルーターによって

最初のトークンが返ってくるまでの時間(TTFT)やリクエストあたり平均レイテンシが短縮されたとのことです (

Introducing NVIDIA Dynamo, A Low-Latency Distributed Inference Framework for Scaling Reasoning AI Models | NVIDIA Technical Blog)。特に繰り返し類似の質問が来るケースではキャッシュ再利用が効いてスイスイ答えられるようになるわけですね。ユーザー体感的にも「あれ、なんかこのAI前よりサクサク返してくれるぞ?」となるかもしれません。

以上のように、Dynamoを使うとケースによって

「倍が当たり前、10倍超えもざら、最大30倍級」というとんでもない性能向上が現れるわけです。もちろんこれは理想的な環境での数字ですが、それでも

従来アプローチの限界を大きく押し広げるものなのは間違いありません。

GPUコストはどれくらい節約できる?

性能が上がるということは、同じ仕事を

より少ないGPUでこなせるということです。Dynamoの導入メリットはそのまま

GPUコストの削減に直結します。NVIDIAも「DynamoはAI工場が

できるだけ低コストで大量のトークン生成を行うのに最適なソリューションだ」とアピールしています 。実際、先述のDeepSeek-R1のケースでは

30倍のスループット向上 = 30倍のコスト削減という衝撃的な数字になります。極論すれば、これまで30ドルかかっていた生成処理が1ドルで済む計算です。さすがに「30倍減」は特殊な例としても、Llama2 70Bでも

半分以下のGPU資源で同じ仕事ができる(2倍効率)わけですから、電気代やクラウド利用料も含めてかなりの節約になることは想像に難くありません。Dynamoによって

GPUあたり処理できるクエリ数が増える = 投下したGPU投資に対するリターンが大きくなるというのはビジネス的にも大きな魅力でしょう。

さらに見逃せないのが、

高価なGPUメモリの節約です。KVキャッシュ・マネージャで解説した通り、Dynamoは必要に応じてキャッシュをCPUやSSDに逃がせます。これによって「メモリ不足を避けるために高額なフラッグシップGPUを追加購入する」といった事態も減らせるかもしれません。つまり

安価なストレージで代用できる部分は代用し、GPUは本当に必要なところだけに使うというコスト意識が徹底されているのです。こうした仕組みのおかげで「推論にかかるインフラ費用を大幅カットできた!」という報告がこれから続々出てくるかもしれません。実際「Dynamoによって推論コストが30分の1に低減」という期待の声も聞かれます。財布にも優しいなんて、嬉しい限りですよね。

Dynamoが活躍するユースケースは?

ここまで読んで、「うちのプロジェクトでも使えるかな?」と思った方もいるでしょう。Dynamoの効果が特に大きいユースケースをまとめると以下のようになります (

NVIDIA Dynamo: Key Highlights)。

-

大規模モデルを扱うAIサービス全般: いわゆる

AIファクトリー的な、大規模言語モデルをフル活用してユーザーにサービス提供しているケースです。多数のGPUノードで巨大モデルを運用しているような環境では、Dynamoの分散最適化による

スループット向上・コスト削減効果は絶大です。

-

リアルタイム対話アプリケーション(Chatbotなど): 即座の応答が要求されるチャットサービスや対話型AIでは

低遅延・高スループットが命です。DynamoはTTFTやITLの改善を通じてユーザー体験を向上させられるため、こうした

対話AIの裏側にうってつけです。特にユーザーごとに会話履歴を持つチャットではスマートルーター+KVキャッシュ再利用が効くため、

同じユーザーの連続した質問に対して高速に回答できるようになります。

-

Retrieval-Augmented Generation(検索強化型の生成AI): 一度検索した知識を踏まえて連続的に文章を生成するようなシステムでは、

共通の文脈(ドキュメントなど)を複数クエリで共有することがあります。Dynamoならその共通文脈をキャッシュに保持しつつ何度も使い回せるため、検索結果の読み込み部分を毎回ゼロから処理する無駄を省けます。結果、

RAGパイプライン全体のスループット向上が期待できます。

-

長い対話や推論ステップを要するエージェント型AI: いわゆる自己対話型エージェント(複数の思考ステップを踏むAI)では、同じコンテキストに対して何度も推論を繰り返します。Dynamoのキャッシュ活用と高速データ転送は、

エージェントの各ステップ間で重複する計算を省略し、全体の推論完了までの時間を短縮します。例えば「思考→行動→観察」を何度もループするようなAIでも、前のループで計算した中間結果を賢く再利用できるイメージです。

-

マルチモデル構成のAIパイプライン: 音声→テキスト→画像のように

複数のモデルを連携させるパイプラインでも、Dynamoは有効です。あるモデルの出力を次のモデルへの長大な入力として与える場合など、Dynamo的な前処理分離やキャッシュ管理によって、

パイプライン全体のスループットを底上げできます。また複数のモデルを同時運用する際の

GPUリソース配分の最適化にも役立つでしょう。

要するに、

「大規模」「高負荷」「文脈の再利用あり」といったキーワードに当てはまるケースであればあるほど、Dynamoは威力を発揮すると思って間違いありません。逆に、極端に小さなモデルを単機で回すだけならオーバースペックかもしれませんが…それは元々Dynamoの守備範囲ではないですね。

導入の際の注意点と現状の制約

夢のように語ってきたDynamoですが、導入にあたって留意すべき点もあります。最後に現在の制約や注意事項を簡単に触れておきます。

-

まだ新しいOSSであり実運用での検証が必要: Dynamoは2025年3月に公開されたばかりの最新技術です。NVIDIA自身「30倍速くなる」と胸を張っていますが、当然ながら実際のワークロードでどこまで効果が出るかは

自分たちで試す必要があるでしょう。一部の専門家からも「理論通りの成果が出るか現場で見極める必要がある」と指摘されています (

What is Nvidia Dynamo and why does it matter to enterprises? | Network World)。まずは小規模テストから始め、自社のシステムにフィットするか確認するのが無難です。

-

統合・最適化の手間がかかる可能性: Dynamoはオープンソースであり柔軟性が高い反面、

使いこなすにはシステム統合やチューニングが必要です。Tritonなど既存の推論サーバから乗り換える場合、設定やAPIの違いを埋めたり、自前のモデル管理と組み合わせたりといったエンジニアリング作業が発生するでしょう。言い換えれば、

魔法の黒箱というよりはカスタマイズ可能なツールキットですので、自社環境に合わせた調整力が求められます。幸いサポートするフレームワークはPyTorchやTensorRT-LLM、vLLMなど多岐にわたるため連携自体は取りやすいはずですが。

-

ハードウェア・ネットワーク要件: Dynamoの真価を発揮するには、それなりに

高速なインターコネクトを備えたGPU環境が望ましいでしょう。例えばGPU同士がNVLinkやInfiniBandでつながっているような環境です。もちろんイーサネットでも動作はしますが、KVキャッシュ転送の遅延が増えれば性能メリットが薄れる可能性があります。またGPUメモリもそれなりに積んでいる方がキャッシュ保持量の点で有利です。

クラウドでスポット利用する小規模GPUなどよりは、

オンプレミスでがっつりGPUクラスタを組むケースの方が向いていると言えます。

-

主にLLM推論向けの設計: Dynamoは「巨大言語モデルなど

推論において文脈保持・逐次生成がボトルネックになるタイプのAI」に特化した最適化がされています。画像認識モデルや勧誘システムのように、入力ごとに独立した小さな計算で済むケースではメリットは少ないでしょう。その意味で、

LLM以外のモデルにはオーバーヘッドが大きくメリットが薄い場合がある点には注意です(今後対応範囲が広がる可能性はあります)。

-

今後のサポート体制: 現状DynamoはオープンソースのGitHubリポジトリで開発が進められていますが、NVIDIAは将来的に自社の企業向け製品群(NVIDIA AI EnterpriseやNIMマイクロサービス)で公式サポートを提供予定としています 。長期的な安定サポートが必要なミッションクリティカル環境では、そうしたエコシステムの成熟を見極めてから採用を判断するのも一つの手でしょう。

以上を踏まえれば、「Dynamo入れたけど思ったほど効果出ないじゃん!」とならないためにも、適材適所で賢く使っていくことが大事ですね。Dynamoは

スケールするほど威力を発揮するツールなので、自分のユースケースがそのスケール感にマッチするかを見極めてください。

まとめ: DynamoでAI推論はもっと楽しくなる?

長々と語ってきましたが、NVIDIA Dynamoの全体像と可能性、伝わりましたでしょうか?その名のとおり「ダイナモ(発電機)」のごとく、今まで捨てられていたエネルギー(GPUパワー)を回収して

推論処理という名の電力に変えてしまおうという発想の技術でした。前処理とデコードを分離する大胆なアーキテクチャ、キャッシュをフル活用する賢い仕組み、そしてハードを余すところなく使い倒す最適化の数々…個人的には「そりゃ効率上がるわけだ!」と膝を打ちました。

もちろん30倍というのはベストケースでしょうし、「話半分、でも試す価値アリ」ぐらいのスタンスで見るのが現実的かもしれません。それでも

推論コストが劇的に下がる可能性は魅力的で、AIサービスを運用するエンジニアにとって心強いツールになるでしょう。何よりオープンソースなので、気になったら実際に試して中身を覗いてみることもできます。

生成AIがますます身近になる中、その裏方である推論基盤にもイノベーションが求められています。NVIDIA Dynamoはその最先端を行く取り組みであり、うまくハマれば「モデルは大きいのに応答はキビキビ、しかもサーバ代はニコニコ」という理想的な世界が現実味を帯びてきます。

参考文献・情報源: NVIDIA公式ブログ (

Introducing NVIDIA Dynamo, A Low-Latency Distributed Inference Framework for Scaling Reasoning AI Models | NVIDIA Technical Blog) (

Introducing NVIDIA Dynamo, A Low-Latency Distributed Inference Framework for Scaling Reasoning AI Models | NVIDIA Technical Blog)、公式発表資料 (

Scale and Serve Generative AI | NVIDIA Dynamo)、開発者コミュニティの解説 (

NVIDIA Dynamo: Key Highlights) (

AI Inference at Scale: Exploring NVIDIA Dynamo’s High-Performance Architecture - Unite.AI)など. Также данные производительности взяты из официальных тестов NVIDIA (

What is Nvidia Dynamo and why does it matter to enterprises? | Network World).